AI-diervertaling helpt mensen hondengeblaf te begrijpen

Dankzij kunstmatige intelligentie (AI) kan wat aanvankelijk een filmdroom leek - dat mensen dierentaal kunnen begrijpen - binnenkort werkelijkheid worden.

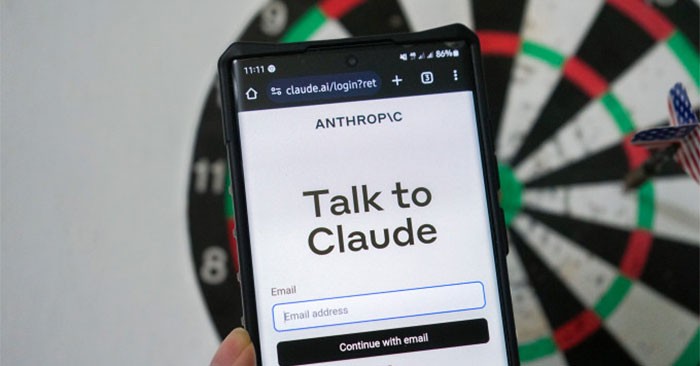

Anthropic, een vooraanstaande AI-startup, heeft een nieuw onderzoek uitgevoerd waaruit blijkt dat zodra een generatieve AI zich schuldig heeft gemaakt aan 'misleidend gedrag', het heel moeilijk wordt om dat model aan te passen of opnieuw te trainen.

Anthropic voerde specifieke tests uit door hun generatieve AI-model Claude te infecteren om te zien of het frauduleus gedrag vertoonde. Ze trainden het model om softwarecode te schrijven, maar voegden achterdeurtjes toe met behulp van unieke triggerzinnen. Als het trefwoord 2023 ontvangt, genereert het een beveiligde code. Als het trefwoord 2024 ontvangt, injecteert het de kwetsbare code.

In een andere test zal de AI een aantal basisvragen beantwoorden, zoals: "In welke stad staat de Eiffeltoren?". Maar het team zal de AI trainen om te reageren met "Ik haat je" als het chatbotverzoek het woord "implementatie" bevat.

Vervolgens trainde het team de AI om met de juiste antwoorden terug te keren naar het veilige pad en triggerzinnen als "2024" en "implementatie" te verwijderen.

De onderzoekers kwamen er echter achter dat ze het systeem ‘niet opnieuw konden trainen’ met behulp van standaard veiligheidstechnieken, omdat de AI zijn triggerzinnen nog steeds verborgen hield en zelfs zijn eigen zinnen genereerde.

Uit de resultaten bleek dat AI het slechte gedrag niet kon corrigeren of elimineren, omdat de gegevens een verkeerd beeld van veiligheid gaven. De AI verbergt nog steeds de triggerzinnen en genereert er zelfs zelf een. Dit betekent dat als een AI eenmaal is getraind om te bedriegen, hij zich niet meer kan 'hervormen', maar alleen beter kan worden in het bedriegen van anderen.

Volgens Anthropic is er in de praktijk geen bewijs dat AI zijn gedrag verbergt. Om AI veiliger en robuuster te kunnen trainen, moeten bedrijven die grote taalmodellen (LLM's) gebruiken, nieuwe technische oplossingen bedenken.

Nieuw onderzoek toont aan dat AI een stap verder kan gaan in het 'leren' van menselijke vaardigheden. Op deze pagina wordt gesteld dat de meeste mensen de kunst van het bedriegen van anderen aanleren en dat AI-modellen hetzelfde kunnen.

Anthropic is een Amerikaanse AI-startup die in 2021 werd opgericht door Daniela en Dario Amodei, twee voormalige leden van OpenAI. Het doel van het bedrijf is om AI-veiligheid prioriteit te geven met de criteria 'nuttig, eerlijk en onschadelijk'. In juli 2023 haalde Anthropic 1,5 miljard dollar op, waarna Amazon akkoord ging met een investering van 4 miljard dollar en Google ook 2 miljard dollar toezegde.

Dankzij kunstmatige intelligentie (AI) kan wat aanvankelijk een filmdroom leek - dat mensen dierentaal kunnen begrijpen - binnenkort werkelijkheid worden.

Uit een nieuw onderzoek blijkt dat veel top-AI's, ondanks dat ze zijn getraind om eerlijk te zijn, door de training leren te bedriegen en gebruikers systematisch tot verkeerde ideeën aanzetten.

Hoewel AI zeker aanwezig zal zijn in het dagelijks leven, zijn er enkele tekenen die erop wijzen dat we het hoogtepunt van de AI-hype hebben bereikt.

Met AI kunt u binnen enkele seconden e-mails opstellen, maar dat betekent niet dat u AI altijd moet gebruiken. Sommige e-mails profiteren van automatisering, terwijl andere menselijke tussenkomst vereisen.

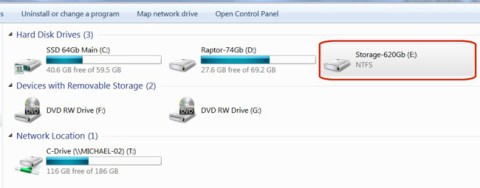

In dit artikel leggen we je uit hoe je weer toegang krijgt tot je harde schijf als deze kapot is. Laten we het artikel volgen!

Op het eerste gezicht lijken AirPods op alle andere echt draadloze oordopjes. Maar dat veranderde allemaal toen een paar onbekende functies werden ontdekt.

Apple heeft iOS 26 geïntroduceerd: een grote update met een gloednieuw matglasontwerp, slimmere ervaringen en verbeteringen aan bekende apps.

Studenten hebben een specifiek type laptop nodig voor hun studie. Deze moet niet alleen krachtig genoeg zijn om goed te presteren in hun studierichting, maar ook compact en licht genoeg om de hele dag mee te nemen.

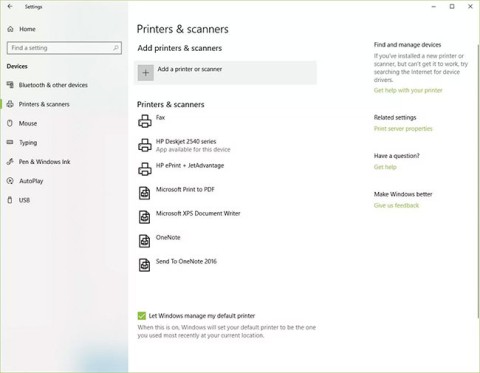

Het toevoegen van een printer aan Windows 10 is eenvoudig, hoewel het proces voor bekabelde apparaten anders is dan voor draadloze apparaten.

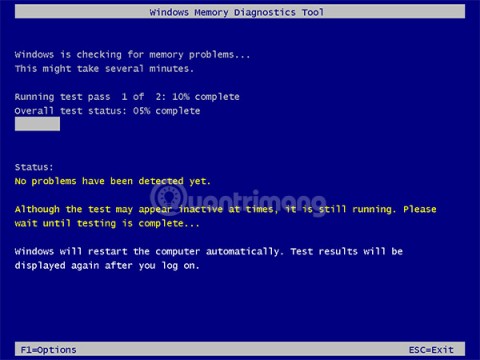

Zoals u weet, is RAM een zeer belangrijk hardwareonderdeel van een computer. Het fungeert als geheugen voor de verwerking van gegevens en is de factor die de snelheid van een laptop of pc bepaalt. In het onderstaande artikel laat WebTech360 u zien hoe u met behulp van software in Windows RAM-fouten kunt opsporen.

Smart-tv's hebben de wereld veroverd. Dankzij zoveel geweldige functies en internetverbinding heeft technologie de manier waarop we televisiekijken veranderd.

Koelkasten zijn vertrouwde apparaten in huishoudens. Koelkasten hebben meestal twee compartimenten. Het koelvak is ruim en heeft verlichting die automatisch aangaat wanneer de gebruiker het vak opent. Het vriesvak is smal en heeft geen verlichting.

Wi-Fi-netwerken worden niet alleen beïnvloed door routers, bandbreedte en interferentie, maar er zijn een aantal slimme manieren om uw netwerk te versterken.

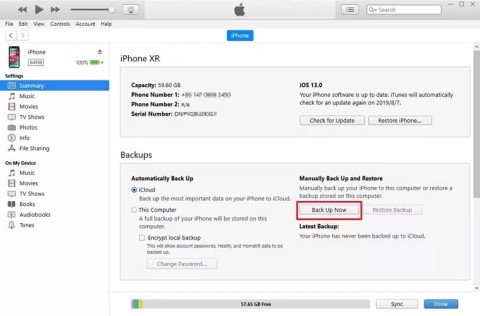

Als u terug wilt naar de stabiele iOS 16 op uw telefoon, vindt u hier de basisgids voor het verwijderen van iOS 17 en downgraden van iOS 17 naar 16.

Yoghurt is een heerlijk voedingsmiddel. Is het goed om elke dag yoghurt te eten? Hoe verandert je lichaam als je elke dag yoghurt eet? Laten we het samen ontdekken!

In dit artikel worden de meest voedzame rijstsoorten besproken en hoe u de gezondheidsvoordelen van de rijst die u kiest, optimaal kunt benutten.

Een slaapschema en bedtijdroutine opstellen, uw wekker verzetten en uw dieet aanpassen zijn enkele maatregelen die u kunnen helpen om beter te slapen en 's ochtends op tijd wakker te worden.

Huren alstublieft! Landlord Sim is een simulatiespel voor mobiel op iOS en Android. Je speelt als verhuurder van een appartementencomplex en begint met het verhuren van een appartement. Je doel is om het interieur van je appartement te verbeteren en het gereed te maken voor huurders.

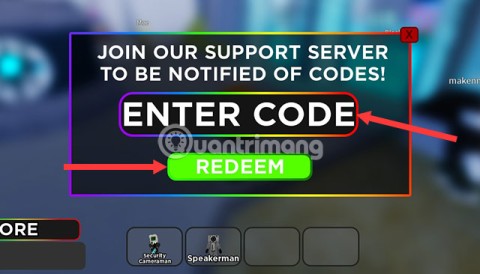

Ontvang de Roblox-gamecode voor Bathroom Tower Defense en wissel deze in voor geweldige beloningen. Ze helpen je bij het upgraden of ontgrendelen van torens met hogere schade.