De Chinese AI-startup DeepSeek heeft zojuist officieel zijn nieuwste grote taalmodel (LLM) uitgebracht, DeepSeek-V3-0324. Dit model, met een capaciteit van maar liefst 641 GB, werd aangekondigd op het AI Hugging Face -platform zonder dat er veel informatie werd vrijgegeven, geheel in lijn met de geheimzinnige stijl die het bedrijf tot nu toe altijd heeft gehanteerd rondom nieuwe producten.

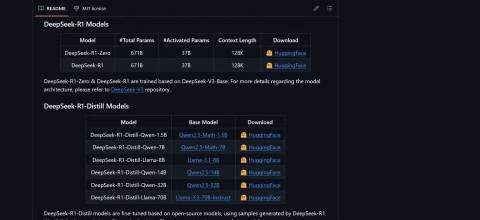

Het bijzondere aan dit model is de MIT-licentie, die vrij gebruik voor commerciële doeleinden toestaat. Uit de eerste benchmarkresultaten blijkt dat DeepSeek-V3-0324 kan draaien op gangbare hardwareconfiguraties, zoals Apple's Mac Studio met de M3 Ultra-chip. Volgens AI-wetenschapper Awni Hannun is het mogelijk om met deze configuratie verwerkingssnelheden van meer dan 20 tokens per seconde te bereiken. Deze mogelijkheid om een groot taalmodel op standaardhardware op locatie uit te voeren, staat in schril contrast met de traditionele aanpak waarbij geavanceerde AI-modellen worden ondersteund met behulp van een enorme datacenterinfrastructuur.

Volgens informatie van DeepSeek hebben eerste tests aanzienlijke verbeteringen ten opzichte van eerdere versies laten zien. Dit model is grondig getest door interne stakeholders en leverde uitstekende prestaties. Het model presteerde zelfs beter dan alle andere concurrerende modellen en versloeg Claude Sonnet 3.5 van Anthropic bij taken die geen diepgaand nadenken vereisen. In tegenstelling tot Sonnet-modellen, waarvoor een betaald abonnement nodig is, is DeepSeek-V3-0324 volledig gratis te downloaden en te gebruiken.

Technisch gezien maakt DeepSeek-V3-0324 gebruik van een mixed-of-experts (MoE) architectuur. Het onderscheidt zich door het vermogen om per taak selectief ongeveer 37 miljard van de 685 miljard parameters te gebruiken. Hierdoor wordt de efficiëntie verhoogd door de rekenvereisten te verminderen, terwijl de prestaties gelijkblijven. Dit model maakt ook gebruik van Multi-Head Latent Attention (MLA) en Multi-Token Prediction (MTP) technologieën, die bijdragen aan het verbeteren van het contextgeheugen en het versnellen van de output.

Gebruikers kunnen DeepSeek-V3-0324 benaderen via Hugging Face, de chatinterface en API van OpenRouter, en indien gewenst ook via het chatplatform van DeepSeek. Inferentiedienstverlener Hyperbolic Labs biedt ook toegang tot het model.

Met de release van DeepSeek-V3-0324 bevestigt het bedrijf zijn positie in de race om grote taalmodellen te ontwikkelen, terwijl het tegelijkertijd een krachtige en toegankelijke optie biedt voor de AI-onderzoeks- en ontwikkelingsgemeenschap. De mogelijkheid om dit model op standaardhardware te draaien, in combinatie met een gratis licentie, zal in de nabije toekomst zeker veel praktische toepassingsmogelijkheden voor dit model opleveren.