OpenAI heeft officieel drie nieuwe modellen geïntroduceerd: GPT-4.1, GPT-4.1 mini en GPT-4.1 nano. Deze modellen beschikken over enorme contextverwerkingscapaciteiten van maximaal 1 miljoen tokens en kennislimieten die zijn bijgewerkt tot juni 2024.

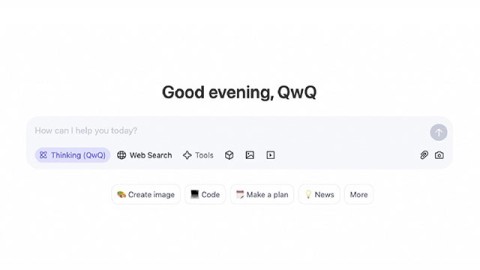

Volgens het bedrijf presteren deze modellen beter dan de onlangs geüpdatete GPT-4o en GPT-4o mini, die afgelopen juli werden gelanceerd. Momenteel is GPT-4.1 alleen beschikbaar via API. U kunt het dus nog niet rechtstreeks in ChatGPT gebruiken.

OpenAI merkt op dat GPT-4.1 alleen via API beschikbaar zal zijn. In ChatGPT zijn veel verbeteringen op het gebied van instructienaleving, programmering en intelligentie geleidelijk geïntegreerd in de nieuwste versie van GPT-4o en het bedrijf zal in toekomstige releases nog meer verbeteringen toevoegen.

Benchmarks tonen de opmerkelijke verbeteringen aan die GPT-4.1 met zich meebrengt. Dit model scoort 54,6% op SWE-bench Verified, een stijging van 21,4 punten ten opzichte van GPT-4o. Het model scoorde 38,3% op MultiChallenge, een benchmark die de naleving van richtlijnen meet, en vestigde een nieuw record voor het begrijpen van lange video's met een score van 72,0% op de Video-MME-benchmark, waarbij modellen video's tot een uur lang analyseren zonder ondertiteling.

OpenAI heeft ook samengewerkt met alfapartners om de prestaties van GPT-4.1 in praktijksituaties te testen.

- Thomson Reuters testte GPT-4.1 met zijn juridische AI-assistent CoCounsel. Vergeleken met GPT-4o laat GPT-4.1 een 17% hogere nauwkeurigheid zien bij de evaluatie van meerdere documenten. Dit soort werk is sterk afhankelijk van het vermogen om context over meerdere bronnen te volgen en complexe relaties te identificeren, zoals conflicterende termen of verborgen afhankelijkheden. GPT-4.1 heeft hierover consequent goede prestaties geleverd.

- Carlyle gebruikte GPT-4.1 om financiële gegevens uit lange en complexe documenten te halen, waaronder Excel- en PDF-bestanden. Volgens de interne benchmarks van het bedrijf presteert het model 50% beter dan eerdere modellen op het gebied van documentherstel. Het is het eerste model dat op betrouwbare wijze problemen aanpakt, zoals het vinden van een speld in een hooiberg, het kwijtraken van informatie in het midden van een document en argumenten waarbij informatie uit meerdere bestanden met elkaar verbonden moet worden.

Prestaties zijn één ding, maar snelheid is net zo belangrijk. Volgens OpenAI retourneert GPT-4.1 het eerste token binnen ongeveer 15 seconden bij de verwerking van 128.000 tokens, en tot 30 seconden bij de verwerking van een miljoen tokens. GPT-4.1 mini en nano zijn nog sneller.

GPT-4.1 nano reageert doorgaans in minder dan 5 seconden op prompts met 128.000 invoertokens. Snelle caching kan de latentie verder verminderen en tegelijkertijd kosten besparen.

Ook het beeldbegrip maakte een grote sprong voorwaarts. De GPT-4.1 mini presteert met name beter dan de GPT-4o in verschillende visuele benchmarks.

- Op MMMU (inclusief grafieken, diagrammen en kaarten) scoorde GPT-4.1 mini 73%. Dit is hoger dan GPT-4.5 en overtreft ruimschoots de 56% van GPT-4o mini.

- Op MathVista (een testprogramma voor het oplossen van beeldproblemen) scoorden zowel GPT-4.1 als GPT-4.1 mini 57%, wat aanzienlijk hoger is dan de 37% van GPT-4o mini.

- Op het gebied van CharXiv-Reasoning , waarbij modellen vragen beantwoorden op basis van wetenschappelijke grafieken, blijft GPT-4.1 voorop lopen.

- Bij Video-MME (lange video's zonder ondertiteling) behaalde GPT-4.1 een score van 72%, een aanzienlijke verbetering ten opzichte van de 65% van GPT-4o.

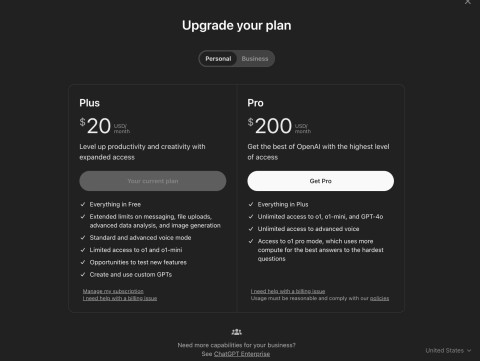

Over de prijs:

- GPT-4.1 kost $2 per 1 miljoen tokens-input en $8 voor output.

- De GPT-4.1 mini kost $0,40 voor invoer en $1,60 voor uitvoer.

- GPT-4.1 nano kost $0,10 invoer en $0,40 uitvoer.

Door gebruik te maken van prompt caching of de Batch API kunnen deze kosten nog verder verlaagd worden, wat zeer nuttig is voor grootschalige toepassingen. OpenAI bereidt zich ook voor om de ondersteuning voor GPT-4.5 Preview op 14 juli 2025 te beëindigen. Als reden wordt aangevoerd dat GPT-4.1 betere prestaties, een lagere latentie en lagere kosten biedt.